El pasado lunes día 2 de febrero se celebró la primera sesión de claustro correspondiente a esta nueva legislatura. Cuando fui elegido representante por el sector A, tomé la decisión de abrir esta «oficina» virtual que diera visibilidad a mi participación como representante, informando por una parte de los aspectos más destacados que se traten en cada sesión, y facilitando por otra el contacto con aquellos a los que represento. Cualquier comentario será por tanto bienvenido.

Durante la sesión se llevaron a cabo elecciones a representantes en Junta de Gobierno y a la comisión de modificación de estatutos. También se aprobó una modificación del estatuto del defensor de la comunidad universitaria a petición de la propia oficina del defensor con objeto principalmente de agilizar los trámites. Se informó al claustro de la creación de nuevos grados, másteres y programas de doctorado, así como de la creación de nuevos institutos de investigación.

Dado el tema de actualidad que tanto rechazo ha provocado en la comunidad universitaria española acerca de la reciente modificación por parte del gobierno del sistema de ordenación de las titulaciones hacia el 3+2, algunas de las intervenciones giraron en torno a este asunto. La conclusión más relevante a este respecto fue la declaración del Sr. Rector de su posición contraria a implantar en nuestra universidad el 3+2. Esperemos, tal y como le pedí en mi intervención, que no modifique su posición en el futuro y nos mantengamos firmes ante este nuevo intento por adelagazar el sistema público de enseñanza.

En el último punto del orden del día «Ruegos y preguntas» solicité intervenir para plasmar mi preocupación por algunos temas que consideré de interés y relevancia para el sector al que represento. Dejo aquí mi intervención:

Desde algunos sectores de nuestra comunidad se le pidió que aplazara este claustro al objeto de asegurar su presencia en la conferencia de rectores que se ha celebrado hoy mismo con el tema en ciernes del 3+2. Teniendo en cuenta que está en juego un paso más en el desmantelamiento de la universidad pública por parte de este gobierno ¿qué razones de peso le han llevado a no aplazar esta sesión y convocarnos unos días más tarde?

En la normativa aprobada en consejo de gobierno de 22 de febrero de 2013 se establece entre otras cosas que a un profesor se le computarán 0,25 créditos por dirigir un trabajo fin de grado o fin de master ¿Significa esto que un profesor sólo está obligado a dedicar 2,5 horas de su tiempo a un estudiante al que dirige su trabajo fin de grado?, porque según el reglamento general de actividades tutoriales (4 dic 2007) las tutorías están dirigidas a reforzar y complementar la docencia, en ningún caso a impartirla. Si es así ¿le parece que esta normativa fomenta la calidad de las enseñanzas que se imparten en la universidad que usted dirige?.

Independientemente de su respuesta voy a hacer una breve reflexión al respecto. Pienso que en realidad esta normativa no es más que un instrumento que usted y su equipo han puesto al servicio de una estrategia silenciosa del gobierno conducente a denigrar el papel del profesorado universitario en el sistema público de enseñanza, proyectando una imagen negativa de todos nosotros como colectivo de privilegiados, ociosos y acomodados con el fin de recortar sin oposición social más recursos a la universidad pública para dirigirlos en última instancia a bolsillos privados. Sin duda habría sido mucho más honesto y positivo para todos aplicar el sentido común, contabilizar el trabajo que realmente hacemos, defendiendo así nuestra honestidad y dignidad como profesores y sencillamente dejar de pagar esas horas, cosa que ya han hecho con anterioridad y que no hubiera sorprendido a nadie.Y por último, este año el gobierno autónomo extremeño ha decidido retrasar la convocatoria de ayudas a los grupos de investigación. Este retraso, además de una considerable merma en nuestra actividad, supone en muchos casos un cese de los contratos de personal técnico de apoyo y gestores de proyectos. ¿Podría indicarme la cifra de personal técnico y gestores de proyectos que se han visto en la calle a causa de este retraso? ¿Considera el sr. rector razonable este proceder de la administración? Lo pregunto porque particularmente me sorprende no haber escuchado ni leído por ningún medio una sola intervención suya al respecto.

A la pregunta del aplazamiento de la sesión de claustro indicó que la fecha de celebración se había consensuado con varios sectores y que no parecía razonable aplazarlo, en su lugar fue el vicerrector de docencia y relaciones institucionales a la reunión de la CRUE. En cuanto a la segunda pregunta, la respuesta fue que la cantidad de 0,25 créditos no se utilizaba como medida de la cantidad de docencia a dedicar a estos trabajos y que la dirección de los trabajos era una tarea más del profesorado que se debía atender como una actividad más a desarrollar en las horas de obligado cumplimiento para todos. Respecto a la última pregunta, no dió dato alguno sobre la cifra solicitada ni tampoco enjuició el proceder de la administración, sencillamente se limitó a comentar que él trataba de resolver los asuntos allí donde se dilucidan y no a través de los medios.

Se comprometió el Sr. rector a convocar una sesión de claustro sobre el mes de abril para debatir entre otros el importante asunto del 3+2.

Voy primero con los aspectos menos «científicos» de la visita. El hotel en que me he hospedado es el Holiday Inn, en Gaithersburg, Maryland, a unos 50 km de Washington. Era el hotel recomendado por la conferencia TRECVID, lo cual ahorra esfuerzos y permite concentrarse en lo importante, la posibilidad de contactar con otros participantes es mayor y la organización pone los medios para trasladarse de un sitio a otro con centro en el hotel. La estancia en el hotel ha sido muy agradable, sin lujos, pero muy funcional y un excelente servicio: buen desayuno, red wifi de muy alta velocidad, habitación amplia y un servicio gratuito de taxi para trasladarse a los alrededores, como poco extraordinario, ¿no? Rellenaré una entrada en tripadvisor, creo que lo merecen.

Voy primero con los aspectos menos «científicos» de la visita. El hotel en que me he hospedado es el Holiday Inn, en Gaithersburg, Maryland, a unos 50 km de Washington. Era el hotel recomendado por la conferencia TRECVID, lo cual ahorra esfuerzos y permite concentrarse en lo importante, la posibilidad de contactar con otros participantes es mayor y la organización pone los medios para trasladarse de un sitio a otro con centro en el hotel. La estancia en el hotel ha sido muy agradable, sin lujos, pero muy funcional y un excelente servicio: buen desayuno, red wifi de muy alta velocidad, habitación amplia y un servicio gratuito de taxi para trasladarse a los alrededores, como poco extraordinario, ¿no? Rellenaré una entrada en tripadvisor, creo que lo merecen.

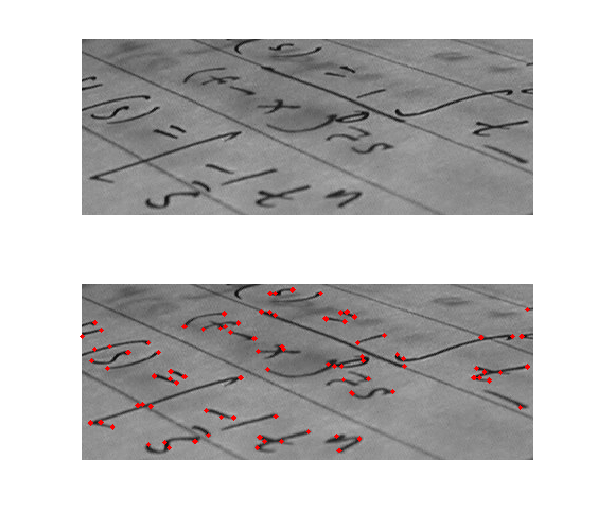

Las características que se extraen de un vídeo pueden ser de caracter visual -pictórico-, sonoro o incluso de texto (tanto el que puede ir incrustado en el vídeo, el cual se puede extraer mediante un reconocedor óptico de caracteres -OCR- como el que va acompañando al documento en forma de metadato, como el título o anotaciones varias colocadas por los usuarios o el propio creador del vídeo), pero para simplificar nos centraremos en las primeras. Las características visuales son a su vez muy variadas también, pero para poner un ejemplo ilustrativo,algunas que se utilizan con frecuencia son los histogramas de color, que consisten en obtener un histograma que muestre para cada color, el número de pixeles de dicho color que contiene la imágen. Tal histograma no es mas que una representación numérica de la imágen en su conjunto (un vector de tantos valores como colores se consideren). Estas características se denominan globales, ya que representan a toda la imágen. Las hay también locales, que se centran en representar zonas puntuales de la imágen que de algún modo sobresalen de las demás y por tanto pueden ayudar a caracterizar en cierto modo a estas imágenes. Un ejemplo típico de este tipo de características son los descriptores denominados SIFT (Scale Invariant Feature Transform).

Las características que se extraen de un vídeo pueden ser de caracter visual -pictórico-, sonoro o incluso de texto (tanto el que puede ir incrustado en el vídeo, el cual se puede extraer mediante un reconocedor óptico de caracteres -OCR- como el que va acompañando al documento en forma de metadato, como el título o anotaciones varias colocadas por los usuarios o el propio creador del vídeo), pero para simplificar nos centraremos en las primeras. Las características visuales son a su vez muy variadas también, pero para poner un ejemplo ilustrativo,algunas que se utilizan con frecuencia son los histogramas de color, que consisten en obtener un histograma que muestre para cada color, el número de pixeles de dicho color que contiene la imágen. Tal histograma no es mas que una representación numérica de la imágen en su conjunto (un vector de tantos valores como colores se consideren). Estas características se denominan globales, ya que representan a toda la imágen. Las hay también locales, que se centran en representar zonas puntuales de la imágen que de algún modo sobresalen de las demás y por tanto pueden ayudar a caracterizar en cierto modo a estas imágenes. Un ejemplo típico de este tipo de características son los descriptores denominados SIFT (Scale Invariant Feature Transform).

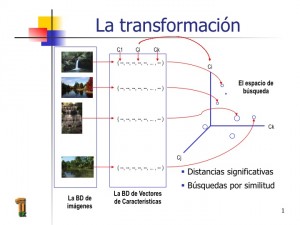

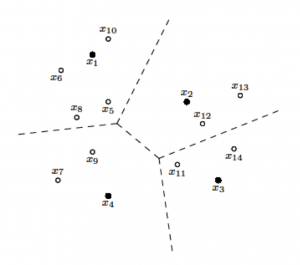

A lo largo de mis años como profesor de estructuras de información me he encontrado con mucha frecuencia con un tipo de error de programación que resulta difícil de detectar. Trataré de describir el error a través de un ejemplo real. Esta mañana revisaba en el laboratorio con uno de nuestros técnicos la respuesta a unos experimentos sobre similitud en colecciones de video digital. Una de las tareas consistía en localizar, dentro de una colección de vectores multidimensionales, los k vectores más próximos a uno dado (un algoritmo típico de

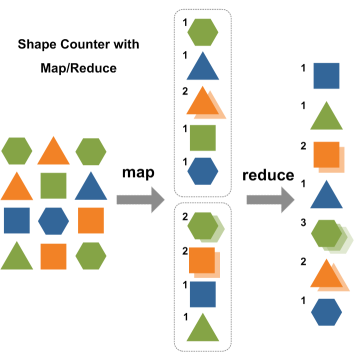

A lo largo de mis años como profesor de estructuras de información me he encontrado con mucha frecuencia con un tipo de error de programación que resulta difícil de detectar. Trataré de describir el error a través de un ejemplo real. Esta mañana revisaba en el laboratorio con uno de nuestros técnicos la respuesta a unos experimentos sobre similitud en colecciones de video digital. Una de las tareas consistía en localizar, dentro de una colección de vectores multidimensionales, los k vectores más próximos a uno dado (un algoritmo típico de  En concreto, nos habló del modelo de programación paralela MapReduce creada por Google para tratar colecciones de datos de gran volúmen que normalmente se escapan a la capacidad de manejo de los sistemas clásicos de gestión de bases de datos (Oracle, SQLServer, MySQL,…).

En concreto, nos habló del modelo de programación paralela MapReduce creada por Google para tratar colecciones de datos de gran volúmen que normalmente se escapan a la capacidad de manejo de los sistemas clásicos de gestión de bases de datos (Oracle, SQLServer, MySQL,…).